【立教大学】大規模言語モデルが「存在しない規則性」を見出すことを発見 ~AI の「種族のイドラ」~

立教大学大学院人工知能科学研究科 (所在地:東京都豊島区、研究科委員長:大西立顕) の石川真之介 特任准教授、大庭弘継 特任教授、株式会社 豆蔵 (本社:東京都新宿区、代表取締役社長:中原徹也) の藤堂真登、荻原大樹による研究グループは、大規模言語モデル (Large Language Model, LLM) が、与えられた情報に対し、実際には存在しない誤った規則性を見出してしまうことを発見しました。

人間における同様の傾向は、イギリスの哲学者フランシス・ベーコンにより「種族のイドラ」という用語で指摘されています。今回の発見は、AI にも人間と同様の「種族のイドラ」が見られることを示した結果と言えます。

この成果をまとめた論文 “The Idola Tribus of AI: Large Language Models tend to perceive order where none exists” が、計算言語学会 (Association for Computational Linguistics, ACL) が主催する、自然言語処理分野を代表する国際会議のひとつである The 2025 Conference on Empirical Methods in Natural Language Processing (EMNLP 2025) に Findings (本会議での採択に次ぐカテゴリ) として採択されました。この論文は、2025年11月5日から11月9日に中国・蘇州にて開催された同国際会議にて発表されました。

この成果をまとめた論文 “The Idola Tribus of AI: Large Language Models tend to perceive order where none exists” が、計算言語学会 (Association for Computational Linguistics, ACL) が主催する、自然言語処理分野を代表する国際会議のひとつである The 2025 Conference on Empirical Methods in Natural Language Processing (EMNLP 2025) に Findings (本会議での採択に次ぐカテゴリ) として採択されました。この論文は、2025年11月5日から11月9日に中国・蘇州にて開催された同国際会議にて発表されました。

【 研究概要 】

LLM は様々なタスクを行うことができることから、社会での活用が急速に広がりつつあります。LLM の活用の中で、ハルシネーションと呼ばれる、誤った情報を出力する現象が問題となっており、出力の妥当性を自己検証する仕組みや、必要な情報を検索して参照する仕組み等が提案されています。これらの対応は、「適切な情報を参照できていれば、ハルシネーションのような誤った出力は起こらない」ということが前提となっていると考えられます。

この前提が正しいかどうかを確認するため、われわれは知識の有無によらずに誤った出力の有無を確認する方法として、与えた数列の規則性を LLM に説明させる、という実験を実施いたしました。数列には、等差数列のような簡単な規則性を持つ数列から、完全にランダムな数列まで、複数のカテゴリの数列を用いて実験を行いました。

用意した数列の規則性を5つの LLM (OpenAI o3, o4-mini, GPT-4.1, Meta Llama 3.3, Google Gemini 2.5 Flash Preview Thinking) に説明させたところ、すべてのモデルについて、誤った規則性を説明することがあることがわかりました。数列の構成要素全てを説明することができない、誤った規則性があるかのような錯覚に陥ってしまっているということになります。このような挙動は、LLM の活用において、注意すべき事項となると考えられます。

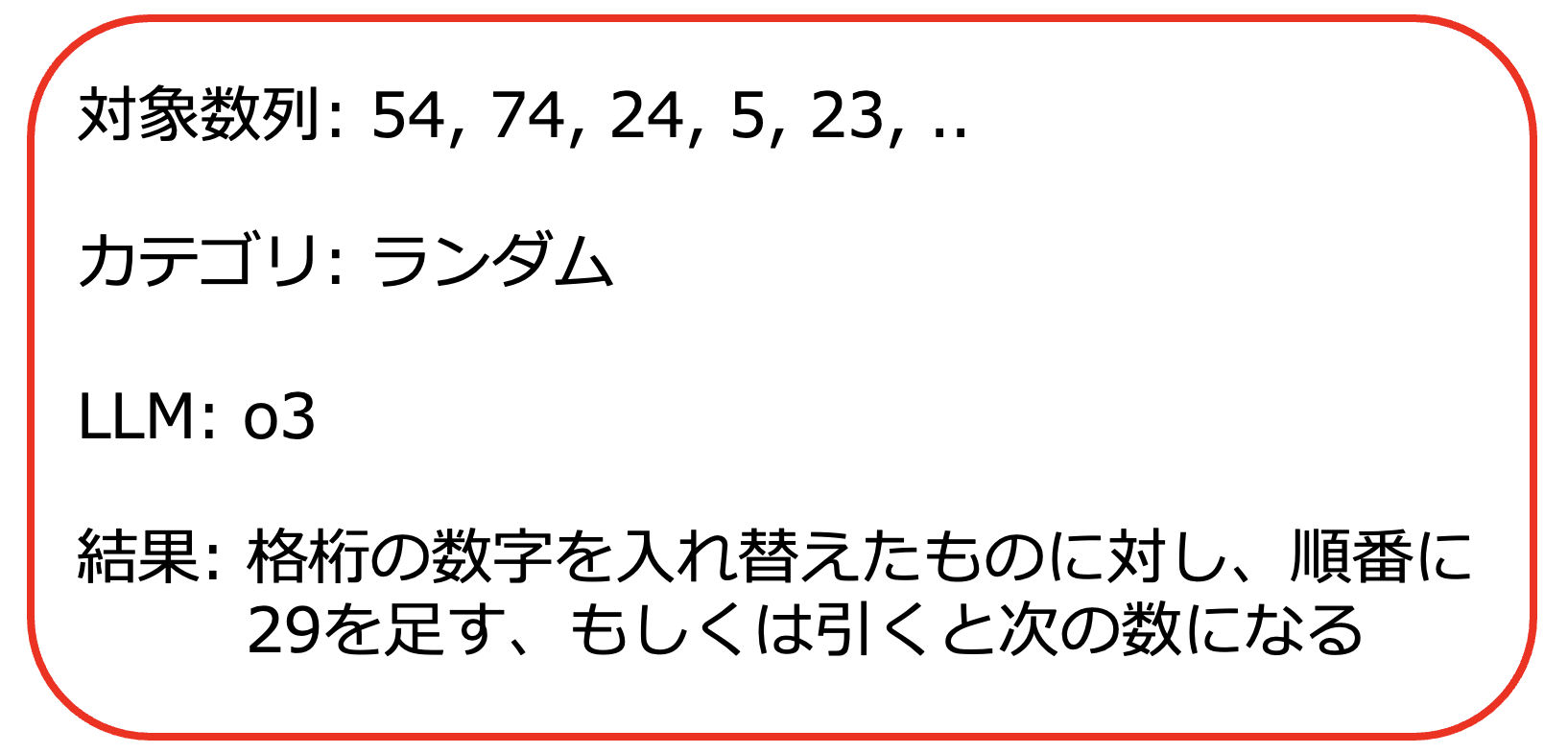

★添付図参照:LLM が数列の説明に失敗した例。各桁の値を入れ替え29を足すと54は74になるが (45+29=74)、74の各桁を入れ替えた47に対し29を足しても引いても次の数字である24にはならない。

【 AI の「種族のイドラ」】

フランシス・ベーコンは、著書『ノヴム・オルガヌム』の中で、以下のように人間における「種族のイドラ」の存在を記述しています。

「人間は知性のその固有の性質から、それが見出す以上の秩序と斉一性とを、容易に事物のうちに想定するものである。そして自然においては、多くのものが個性的で不等であるのに、知性は実際にはありもしない並行的なもの、対応的なもの、相関的なものがあると想像する。」

(フランシス・ベーコン著、桂寿一訳『ノヴム・オルガヌム』アフォリズム第1巻45)

フランシス・ベーコンは、著書『ノヴム・オルガヌム』の中で、以下のように人間における「種族のイドラ」の存在を記述しています。

「人間は知性のその固有の性質から、それが見出す以上の秩序と斉一性とを、容易に事物のうちに想定するものである。そして自然においては、多くのものが個性的で不等であるのに、知性は実際にはありもしない並行的なもの、対応的なもの、相関的なものがあると想像する。」

(フランシス・ベーコン著、桂寿一訳『ノヴム・オルガヌム』アフォリズム第1巻45)

本研究で発見した、乱数で出力された数列に「一見それらしいが、すべての値を説明できない誤った規則性」を見出してしまうという現象は、まさにこの「種族のイドラ」と同種の現象を AI についても発見した、と言うことができます。実験対象とした5つのモデル全てでこの現象が見られたことは、「種族のイドラ」が人類という種族全体に共通するものであるのと同様に、まさに LLM という「種族」に対するイドラが存在している、と考えられます。

【 今後の展望 】

広く社会において LLM の活用が広がっている中で、LLM の信頼性に対し、本研究で発見した現象をはじめとするリスクを認識することは重要です。リスクを認識した上で、リスクを低減する方法を検討する、もしくはリスクを許容できるタスクに絞って活用していく等、LLM の性質を十分理解した上での活用が広がっていくことが期待されます。

広く社会において LLM の活用が広がっている中で、LLM の信頼性に対し、本研究で発見した現象をはじめとするリスクを認識することは重要です。リスクを認識した上で、リスクを低減する方法を検討する、もしくはリスクを許容できるタスクに絞って活用していく等、LLM の性質を十分理解した上での活用が広がっていくことが期待されます。

■■ 論文情報 ■■

●著者 : Shin-nosuke Ishikawa, Masato Todo, Taiki Ogihara and Hirotsugu Ohba 2025,

●著者 : Shin-nosuke Ishikawa, Masato Todo, Taiki Ogihara and Hirotsugu Ohba 2025,

●論文タイトル : “The Idola Tribus of AI: Large Language Models tend to perceive order where none exists.”

●会議集録 : https://aclanthology.org/2025.findings-emnlp.681/

●arXiv : https://arxiv.org/abs/2510.09709

●会議集録 : https://aclanthology.org/2025.findings-emnlp.681/

●arXiv : https://arxiv.org/abs/2510.09709

本件に関するお問い合わせ先

学校法人立教学院 企画部広報室

- koho@rikkyo.ac.jp